Isso é pra NVidia aprender, se a maioria do consumidor fizer bem o seu papel todo mundo sai ganhando!Amanhã e dia 14 vai ter várias rtx 4090 para comprar, essa série está bem fraca no lançamento.

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

[TÓPICO DEDICADO] NVIDIA GeForce RTX 4XXX

- Iniciador de Tópicos neo666

- Data de Início

Quero saber como o pessoal vai fazer pra meter 4 GPUs dessa em um sistema.

Só usando plataforma de servidor...

Tanto Intel e Amd estão limitados até 16x PCIE 5.0, então usaram no teste o máximo da série customer que é 8x + 8x PCIE 5, sendo que 8x PCIE 5.0 tem a mesma largura de 32gb/s do 16x PCIE 4.

Num Epic Milan da vida que tem até 128 PCIE 4.0 da pra ligar até 8 (teoricamente).

Edit: Esqueci tem o ThreadRipper Pro... só não pode esquecer das 2x Corsair 1600 watts

Fora os threadripper, sempre tem os loucos que metem 4 em plataforma consumer mesmo, joga tudo pra PCIe 4.0, usa splitters e deixa cada gpu em 4x, ainda sobra lane pra NVMe sem dor de cabeçaSó usando plataforma de servidor...

Tanto Intel e Amd estão limitados até 16x PCIE 5.0, então usaram no teste o máximo da série customer que é 8x + 8x PCIE 5, sendo que 8x PCIE 5.0 tem a mesma largura de 32gb/s do 16x PCIE 4.

Num Epic Milan da vida que tem até 128 PCIE 4.0 da pra ligar até 8 (teoricamente).

Edit: Esqueci tem o ThreadRipper Pro...

Os artefatos não parecem ser um problema acima de 120fps, eles só aparecem nos frames interpolados que são 1/3 dos frames totais, mas o fato do DLSS 2 apresentar um resultado melhor em performance mode meio que torna o DLSS3 inútil.Boa explicação. Quanto aos artefatos ou glitches eu particularmente não ligo, pois acredito que em uma gameplay fluida sejam praticamente imperceptíveis. Já em relação ao input lag, faria diferença em um jogo como SF6, por isso exemplo, onde os golpes possuem frames de execução?

SF6 e Guilty Gear são exemplos extremos, ninguém usaria DLSS 3 nesses jogos e nem os devs implementariam por saber que iria piorar muito os games, mas tem vários games single player onde esse tipo de delay afeta muito, Doom Eternal com 2 frames adicionais de delay fica injogável nas dificuldades mais altas onde você precisa ser capaz de saltar e aplicar tiros precisos em pontos fracos dos inimigos enquanto se move, o fato de não poder travar o fps deixa tudo pior já que esse delay vai variar com o frame rate, se você pudesse travar em 120fps por exemplo, ao menos esse input lag fica consistente e permite que você se acostume.

NVIDIA GeForce Game Ready 522.25 WHQL

Download Link

Our DirectX 12 optimizations apply to GeForce RTX graphics cards and laptops, though improvements will vary based on your specific system setup, and the game settings used. In our testing, performance increases were found in a wide variety of DirectX 12 games, across all resolutions:

- Assassin’s Creed Valhalla: up to 24% (1080p)

- Battlefield 2042: up to 7% (1080p)

- Borderlands 3: Up to 8% (1080p)

- Call of Duty: Vanguard: up to 12% (4K)

- Control: up to 6% (4K)

- Cyberpunk 2077: up to 20% (1080p)

- F1Ⓡ 22: up to 17% (4K)

- Far Cry 6: up to 5% (1440p)

- Forza Horizon 5: up to 8% (1080P)

- Horizon Zero Dawn: Complete Edition: up to 8% (4k)

- Red Dead Redemption 2: up to 7% (1080p)

- Shadow of the Tomb Raider: up to 5% (1080p)

- Tom Clancy’s The Division 2: up to 5% (1080p)

- Watch Dogs: Legion: up to 9% (1440p)

Paguei boleto da suprim liquid mesmo. Loja do pombo só despacha dia 30 pqp, o mais legal que falei com a mulher ontem que ia trocar de placa, ia gastar uns 7k, ela ficou putona.

aqui hoje no trabalho de boa emito o boleto e esqueço que meu e-mail está aberto no pc de casa. Me liga agora - Há que legal foi 2x de 7k né, ou eu não tinha ouvido direito, chegar em casa a gente conversa... IHAAA, dormir no sofá uns dias não vai me fazer mal... foi por uma boa causa...

Te prepara que saldo final dessa 4090 vai ser +20K... kkk ... quando ela quiser algo vai lembrar desse gasto extra.

Lembram que o derbauer disse q teve resultados estranhos com undervolting? Por isso ele preferiu limitar o power no app..

Pois bem, tem mais gnt testando isso. A 4090 nao tem apenas 1 clock gpu; sao 3 valores.

O undervolt pode nao ter mto impacto no clock principal da gpu, mas afeta os outros 2. E isso causa redução do desempenho....

Pois bem, tem mais gnt testando isso. A 4090 nao tem apenas 1 clock gpu; sao 3 valores.

O undervolt pode nao ter mto impacto no clock principal da gpu, mas afeta os outros 2. E isso causa redução do desempenho....

Pessoal, sobre os conectores de energia, está vindo algum adaptador de energia para essas placas costumizadas vendidas (ou até mesmo sendo vendidas nos padrões das fontes atuais) ou ainda somos obrigados a conseguir um adaptador por fora?

Todas as placas estão vindo com adaptador. Alguns modelos vêm com 3x 8 pin, outras com 4x, mas todas elas podem ser ligadas e usadas com apenas 3x 8 pin. O adaptador é inteligente e reconhece quantos cabos estão conectados, fazendo assim com que a placa rode em modo até 450w ou os full 600w - se o seu modelo permitir.

Sobre o debate mais cedo do DLSS3... Na minha opinião eu penso que independente se vocês planejam ou não usar, sem dúvidas é uma tecnologia muito promissora e que certamente tende a amadurecer muito. Mesmo hoje ela estando em "beta" os resultados são muito surpreendentes. Sim, tem muita margem pra melhor - e eu tenho a certeza de que irão.

Claro que muitas pessoas que focam em frames mais limpos, como jogadores competitivos, não vão e nem deverão usar, mas também não é e nunca será o público-alvo desta tecnologia - convenhamos que também nem precisam tendo em visto que todos os jogos competitivos são superleves e os players metem tudo no low pra cuspir o máximo de FPS que a VGA consegue.

Enfim, vamos ter paciência e acompanhar as possíveis melhorias e ajustes que o DLSS vai sofrer no futuro. Quem lembra o DLSS 1.0? Era simplesmente nojento e injogável, hoje já melhorou demais!

PS. Falando nisso, o único user do Reddit que alegou ter furado o bloqueio do DLSS3 conseguiu comprovar algo ou ficou só no boca a boca mesmo?

Claro que muitas pessoas que focam em frames mais limpos, como jogadores competitivos, não vão e nem deverão usar, mas também não é e nunca será o público-alvo desta tecnologia - convenhamos que também nem precisam tendo em visto que todos os jogos competitivos são superleves e os players metem tudo no low pra cuspir o máximo de FPS que a VGA consegue.

Enfim, vamos ter paciência e acompanhar as possíveis melhorias e ajustes que o DLSS vai sofrer no futuro. Quem lembra o DLSS 1.0? Era simplesmente nojento e injogável, hoje já melhorou demais!

PS. Falando nisso, o único user do Reddit que alegou ter furado o bloqueio do DLSS3 conseguiu comprovar algo ou ficou só no boca a boca mesmo?

Acho que são duas situações, primeiro como é trabalhoso esses testes, o pessoal se focou só no comparativo de GPU nessa semana de lançamento, e segundo, os intel novos saem semana que vem, daí já esperar pra fazer os testes com eles.Incrivelmente não consigo achar NENHUM teste de scale de CPU com a 4090... wtf

Será q a nivida proibiu até isso hahah

o jaquetinha mandou todo mundo testar dls3... é só oq se acha no youtube

O carinha da Technopowerup já prometeu o comparativo de CPUs, a princípio ele falou em 5800x, 7600x, 7950x, 12900k e 13900k, mas provavelmente vai meter o 5800x3d também no meio..

Te falo que essa história de driver muitas vezes é má vontade, ou até preconceito. OK que foi a AMD mesmo que criou isso com os drivers zuados da série passada, mas nas 6XXX eles acertaram demais. Claro que ainda há erros, mas longe, muito longe do que a galera que nem tem, prega.O problema da AMD não é rasterização, pelo menos não nos últimos anos. Olha o exemplo das 6800 XT e 6900 XT... Placas com ótima performance bruta e bom preço quando foram lançadas, mas que não conseguiram conquistar a atenção do público da Nvidia. O motivo? Pós-venda da AMD é ruim. Drivers cagados de forma recorrente, demora nas soluções, etc. No geral, a grande maioria do público sabe disso e prefere se manter ou ir de Nvidia, nem que para isso tenha que pagar um pouco mais caro.

Isso não vai mudar enquanto a AMD não melhorar (e muito) nesse aspecto. Ela pode até lançar uma GPU com o mesmo desempenho da 4090 e custando uns 300 USD a menos, mas se continuar com esse pós-venda porco, a GPU vai flopar. É algo simples de se raciocinar e entender.

Acho que são duas situações, primeiro como é trabalhoso esses testes, o pessoal se focou só no comparativo de GPU nessa semana de lançamento, e segundo, os intel novos saem semana que vem, daí já esperar pra fazer os testes com eles.

Pior q faz sentido mesmo.. pode ser q estejam esperando o embargo da intel pra liberar o comparativo já com os novos cpus

O carinha da Technopowerup já prometeu o comparativo de CPUs, a princípio ele falou em 5800x, 7600x, 7950x, 12900k e 13900k, mas provavelmente vai meter o 5800x3d também no meio..

nao confio mais nele...vai tentar defender o 5800x q ele usou nos testes kkkkkkkkkk

Só lembrando pra qualquer possível desajustado que queira comprar a 4090 pra jogar em 1440p/1080p que a placa não possui scheduler hardware.

Basicamente desde Kepler virou software, mas agora com uma placa desse porte faz falta.

Qqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqqq?

Só boca a boca mesmo, acho que a build do CP com DLSS3 ainda não tá disponível, mas quando sair fica fácil do resto das pessoas testar.PS. Falando nisso, o único user do Reddit que alegou ter furado o bloqueio do DLSS3 conseguiu comprovar algo ou ficou só no boca a boca mesmo?

Se não me engano, o 5800x foi pq os testes com outras GPUs antes usaram essa CPU também, aí fica melhor de comparar assim.nao confio mais nele...vai tentar defender o 5800x q ele usou nos testes kkkkkkkkkk

--- Post duplo é unido automaticamente: ---

Tem como explicar melhor isso aí?Só lembrando pra qualquer possível desajustado que queira comprar a 4090 pra jogar em 1440p/1080p que a placa não possui scheduler hardware.

Basicamente desde Kepler virou software, mas agora com uma placa desse porte faz falta.

bem provável...ficou com preguiça de refazer tudo..hahaSe não me engano, o 5800x foi pq os testes com outras GPUs antes usaram essa CPU também, aí fica melhor de comparar assim.

--- Post duplo é unido automaticamente: ---

4K

73,9% em cima da 6950xt

59,4% em cima da 3090ti

not bad kkk

Só boca a boca mesmo, acho que a build do CP com DLSS3 ainda não tá disponível, mas quando sair fica fácil do resto das pessoas testar.

Se não me engano, o 5800x foi pq os testes com outras GPUs antes usaram essa CPU também, aí fica melhor de comparar assim.

Vamos ver, né. Eu não duvido que funcione, pelo contrário, tenho certeza de que funciona nas 3000 e 2000. Acho que em algum moento teve um funcionário ou engenheiro da própria Nvidia que confirmou que seria capaz de "rodar" em outras vgas. Porém, resta saber o quão bom (ou ruim) isso ficaria. Pois caso não ficasse legal por alguma limitação eu entendo a decisão de restringir o uso, afinal, é melhor não ter do que ter e rodar com problemas, isso poderia até causar uma imagem bem negativa pro DLSS3 e eles não iriam querer isso.

Quanto ao uso das CPUs eu acho injusto usar no review um CPU que claramente não gargala nas outras VGAs mas gargala na 4090, o elo mais fraco claramente estaria na CPU hahah.

Vamos ver, né. Eu não duvido que funcione, pelo contrário, tenho certeza de que funciona nas 3000 e 2000. Acho que em algum moento teve um funcionário ou engenheiro da própria Nvidia que confirmou que seria capaz de "rodar" em outras vgas. Porém, resta saber o quão bom (ou ruim) isso ficaria. Pois caso não ficasse legal por alguma limitação eu entendo a decisão de restringir o uso, afinal, é melhor não ter do que ter e rodar com problemas, isso poderia até causar uma imagem bem negativa pro DLSS3 e eles não iriam querer isso.

Quanto ao uso das CPUs eu acho injusto usar no review um CPU que claramente não gargala nas outras VGAs mas gargala na 4090, o elo mais fraco claramente estaria na CPU hahah.

Então, se pegar o texto do cara tem uns comentários sobre instabilidade e erros (crash do jogo).

Desde kepler o scheduler (pipeline hardware) foi retirado em prol de uma solução via software. Na época a diferença de performance não justificava a área a mais no chip e a AMD tinha um monte de problemas que não faziam a placa performar direito. AMD atualmente tem a solução integrada no chip, e em alguns casos dá pra ver a diferença:Tem como explicar melhor isso aí?

Com a solução via software o gargalo chega antes por causa da velocidade de organização.

Exatamente, eu ODEIO a Nvidia por motivos óbvios, mas eu só pego AMD se na geração anterior os problemas tiverem sido baixos (e a performance x preço for interessante...), pois das pessoas que tem GPU AMD que eu conheço pessoalmente e jogam jogos atuais as três reclamam de problema, enquanto isso eu sempre usei NVidia e sempre fico de boas.O problema da AMD não é rasterização, pelo menos não nos últimos anos. Olha o exemplo das 6800 XT e 6900 XT... Placas com ótima performance bruta e bom preço quando foram lançadas, mas que não conseguiram conquistar a atenção do público da Nvidia. O motivo? Pós-venda da AMD é ruim. Drivers cagados de forma recorrente, demora nas soluções, etc. No geral, a grande maioria do público sabe disso e prefere se manter ou ir de Nvidia, nem que para isso tenha que pagar um pouco mais caro.

Isso não vai mudar enquanto a AMD não melhorar (e muito) nesse aspecto. Ela pode até lançar uma GPU com o mesmo desempenho da 4090 e custando uns 300 USD a menos, mas se continuar com esse pós-venda porco, a GPU vai flopar. É algo simples de se raciocinar e entender.

--- Post duplo é unido automaticamente: ---

Mas aí é que tá, se a desculpa de "incompatibilidade de hardware" fosse 100% real o cara deveria ter crash instantâneo assim que abrisse o jogo, diferente do que acontece...Então, se pegar o texto do cara tem uns comentários sobre instabilidade e erros (crash do jogo).

Mas aí é que tá, se a desculpa de "incompatibilidade de hardware" fosse 100% real o cara deveria ter crash instantâneo assim que abrisse o jogo, diferente do que acontece...

Não é incompatibilidade...

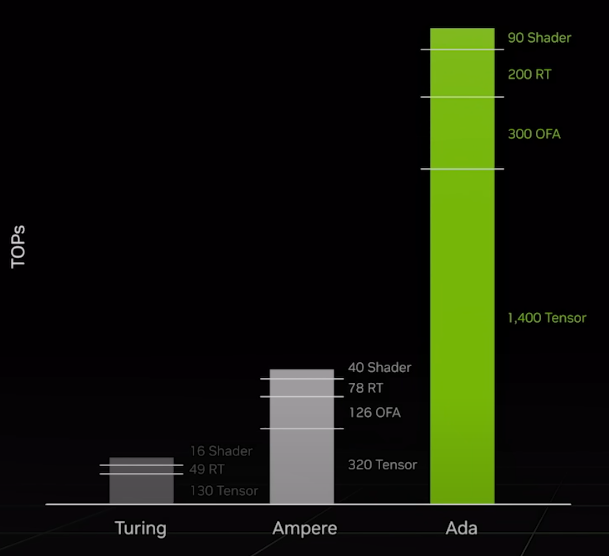

É que a série 4xxxx tem um mega reforço no hardware que faz o DLSS e Frame Generation.

Segundo o post do engenheiro, não compensaria, pois demoraria mais o Frame Generation que o raster normal devido a diferença de hardware.

Alias, esse é justamente o ponto do leak/desbloqueio, o cara está falando que a 2070 (Turing) está fazendo a mesma coisa que Ada Lovelace, mesmo com esse abismo de hardware de diferença.

Turing não tem nem OFA (Optic Flow Accelerator) se fosse uma 3070, seria mais plausível e ausência do vídeo só piora as coisas.

-------------------------------------------------------------

E mais um rodada confusa sobre o novo conector...

Em resumo.

Existem 2 sensor wires no adaptador, se 3 cabos estão conectados, ou seja 450w (150w + 150w + 150w) a placa identifica 1 sensor wire e 450w disponível e funciona com as limitações.

Se ligar os 4 cabos os 2 sensor wires falam "pé na tábua" é libera os 600w (133%).

niguem falou que era perfeito, tem varios teste mostrando os problemas, e so amadurecer como toda nova tecnologia ue.Se o que importasse fosse mais frame a galera iria só diminuir a qualidade e resolução.

Tudo no talo, até artefatos

Caraio vc fez pacto com a nvidia pra passarem vergonha juntos?

--- Post duplo é unido automaticamente: ---

o proprio dlss ainda nao perfeito ,tem la seus problemas.

nao acho errado tentar inovar.

calma amigo, voce gosta e rotular os outros e nao gosta de ser contrariado.

GANHO DE FRAMES COM QUALIDADE GRAFICA .

ficou claro agora ????????

e outra no competitivo a galera joga na pior qualidade possivel para mais estabilidade e granhos de frames.

Users who are viewing this thread

Total: 2 (membros: 0, visitantes: 2)