Temos que olhar o cenário como um todo, arredondando os números, do Q2 para o Q3:Não me surpreende os 4% da Intel, mas a AMD com apenas 8%, só isso ?

O que a Intel fez em "3 meses", a AMD não conseguiu fszer em décadas...tá certo isso??

NVIDIA: 80% -> 86%

AMD: 20% -> 10%

INTEL: 0% -> 04%

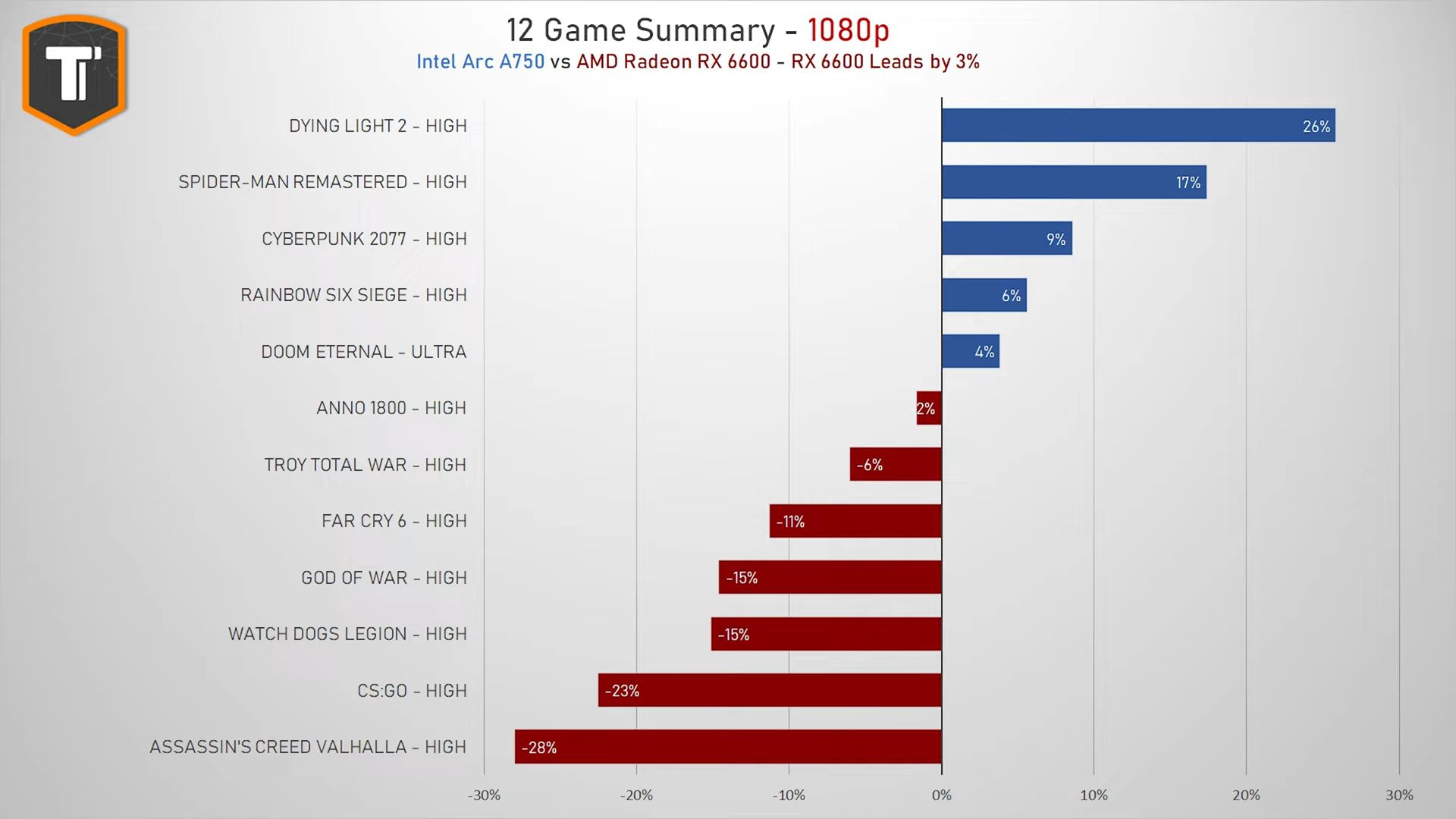

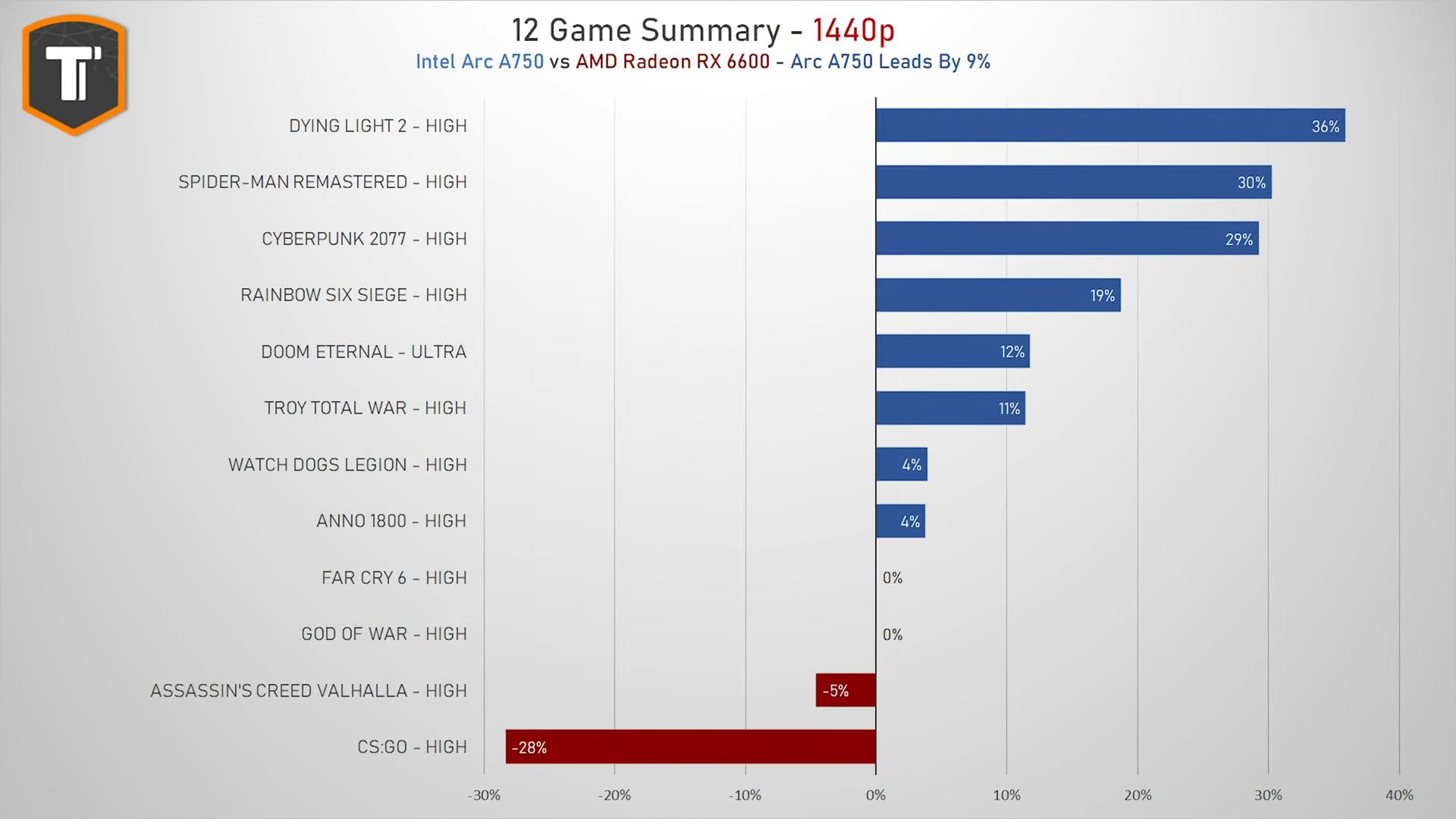

No caso, tanto NVIDIA quanto Intel pegaram os ~10% que a AMD perdeu, e o que a Intel fez para abocanhar 40% dessa fatia? A compatibilidade com softwares para trabalho é um dos motivos; Outro é pelo fator novidade, muitas pessoas compraram para testar a placa; Teve também quem comprou para ter um setup full Intel (sim, isso mesmo); Mas uma boa parcela comprou mesmo por causa da unidade de encode/decode dela, para stream e afins. Ah, a mão da própria Intel empurrando OEMs a embarcarem suas GPUs também contribuiu para esse crescimento acelerado.

A grosso modo desses 4% da Intel somente 1% (chutando) comprou para jogar, e com os preços atrativos (as de entrada, e lá fora) da ARC não custa arriscar, é um lançamento corajoso por querer bater de frente com duas gigantes, e tem sempre aquele caso: Se por ventura a Intel decidir desistir do mercado de dGPU (de novo), você terá uma relíquia em mãos para histórias futuras (como hoje é com quem tem uma Auburn/i740, ou uma Portola/i752).

Some isso ao fato da falta de confiança do/no mercado (inundado de Radeon e GeForce vindas de mineração) e chegamos ao "por que não?", e esse número surgiu. Como qualquer novidade que aparece, vários influenciadores contribuíram para a participação alcançar esses 4%, logo a próxima análise pode mostrar um crescimento menos acentuado, já que a partir de agora qualquer ganho da Intel tenderá a vir de seu próprio esforço, ou seja, de resultados entregues, seja em jogos, seja em aplicações profissionais e/ou streaming.

Temos a primeira resposta de três perguntas possíveis desses números. As segunda e terceira são "o que a NVIDIA fez/faz para estar com ~90% do mercado" e o que a AMD anda fazendo para ter apenas 8%"... essas são as verdadeiras perguntas