Sobre o mercado de HPC - High Performance Computing

Supercomputadores Exascale alimentados pela AMD

Frontier

A AMD, em colaboração com o Departamento de Energia dos EUA, com o Oak Ridge National Laboratory e com a Cray Inc., desenvolveu o supercomputador Frontier, que deverá oferecer mais de 1.5 exaflops de pico de poder de processamento. Proposto para ficar online em 2021. O Frontier foi desenvolvido com:

- Processadores personalizados AMD EPYC™, otimizados para HPC e IA

- Placas gráficas Radeon Instinct™ feitas sob medida e habilitadas para HBM

O Frontier ampliará os limites das descobertas científicas, aumentando dramaticamente o desempenho da inteligência artificial (IA) e da inteligência e simulação análitica em escala, ajudando os cientistas a implementar mais cálculos, identificar novos padrões de dados e desenvolver métodos inovadores de análise de dados para acelerar o ritmo das descobertas científicas.

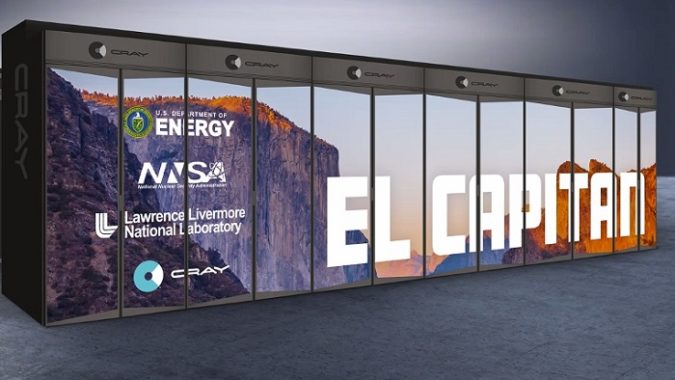

El Capitan

Para possibilitar poder de processamento de dupla precisão maior que 2 exaflops, o Departamento de Energia dos EUA, o Lawrence Livermore National Laboratory e a HPE se uniram com a AMD para projetar o El Capitan, que deverá ser o supercomputador mais rápido do mundo, com entrega esperada nos primeiros meses de 2023. O El Capitan usará produtos de última geração que incorporam melhorias do projeto personalizado de processador no Frontier.

- A próxima geração dos processadores AMD EPYC, de codinome “Genoa”, estarão equipados com núcleo de processador “Zen 4", oferecendo compatibilidade com memórias e subsistemas I/O de última geração para trabalho com IA e HPC.

- O próxima geração das placas gráficas Radeon Instinct, baseadas em uma nova arquitetura otimizada para computação para trabalho com HPC e IA, usarão memória de última geração com alta largura de banda para desempenho otimizado para deep learning.

Este projeto será excelente para análise de dados com IA e aprendizagem de máquina para criar modelos mais rápidos, mais precisos, e capazes de quantificar a incerteza de suas previsões.

Coming in 2023, this system will become the U.S. Department of Energy's third exascale-class supercomputer, joining its Shasta-based sisters Frontier and Aurora at the Oak Ridge and Aurora National Laboratories.

www.cray.com

There is a constant push and pull between budget and architecture in supercomputing, and the passing of time has not made anyone’s arms tired as yet on

www.nextplatform.com

A supercomputação há muito caiu da curva exponencial.

Conversamos com Erich Strohmaier, cientista sênior e líder do grupo de pesquisa de desempenho e algoritmos do Laboratório Nacional Lawrence Berkeley e um dos co-criadores da lista Top500, em uma entrevista que será exibida hoje mais tarde na

Next Platform TV , e ele nos diz que, com apenas 51 máquinas novas na lista, esse é o nível mais baixo de rotatividade que ele vê desde que os rankings foram iniciados em 1993. Não está claro se essa pausa está sendo causada pelo COVID-19, mas provavelmente existem algumas pressões orçamentárias na metade inferior da lista. Mas também não podemos culpar totalmente a pandemia do vírus corona. (Também temos uma entrevista com Wu Feng, da Virginia Tech, que reúne a lista Green500, que chegará hoje mais tarde na

Next Platform TV . Portanto, fique atento a isso.)

O desempenho agregado na lista Top500 é de 2,23 exaflops, um aumento de 35,2% em relação à lista de novembro de 2019 e quase exclusivamente devido à adição do sistema Fugaku. Agora você precisa de 1,24 petaflops para fazer a lista. Em termos de desempenho agregado - que estamos começando a considerar uma métrica melhor do que a contagem do sistema para avaliar a propensão a investir em supercomputação por nações - os Estados Unidos tiveram 644 petaflops em comparação com a China com 565 petaflops e agora o Japão com 530 petaflops.

Existem muitas máquinas na lista das 500 principais enviadas por hiperscalers e criadores de nuvens, que dominam o meio da lista e que têm pouco a ver com HPC ou AI, para usar a classificação de país ou fornecedor para dizer o que é significativo em relação ao HPC ou AI. Nós reclamamos muito disso e não vamos nos repetir. A lista precisa ser

os supercomputadores Top500 , não

os clusters Top500 que executaram o Linpack desta vez e enviaram resultados.

Dado tudo isso - sistemas reais de HPC e AI empilhados com sistemas de nuvem e hiperescala que simplesmente executaram o teste para se gabar corretamente de fornecedores e países - não é surpresa que os sistemas que usam processadores X86 dominem a lista, com 481 das 500 máquinas baseadas no X86.

Desses, 469 usam processadores Intel Xeon ou Xeon Phi (ou um mix), 11 inteiros usam processadores AMD Epyc e o último usa um clone Epyc do Hygon da China. Existem quatro máquinas baseadas na arquitetura Arm da lista, três delas baseadas no AFX64 da Fujitsu e uma delas no processador ThunderX2 da Marvell.

Um total de 144 máquinas possui aceleradores de alguma forma fornecendo seu poder de ponto flutuante, e a maioria destes - 135 sistemas - está usando aceleradores de GPU Nvidia.

It is no surprise that the key criteria that organizations look for when shopping for high performance computing storage is performance. It’s right there

www.nextplatform.com

Cada dia de inatividade custa às empresas de menos de US $ 100.000 a mais de US $ 1 milhão.

Um ponto do estudo foi que, enquanto 82% das organizações disseram estar relativamente satisfeitos com o atual fornecedor de armazenamento de HPC, uma "minoria substancial" disse que provavelmente trocaria de fornecedor na próxima vez em que atualizar seus sistemas principais de HPC, com a "implicação aqui é que um número razoável de compradores de armazenamento de HPC está examinando os fornecedores em busca de competências e preços. ”

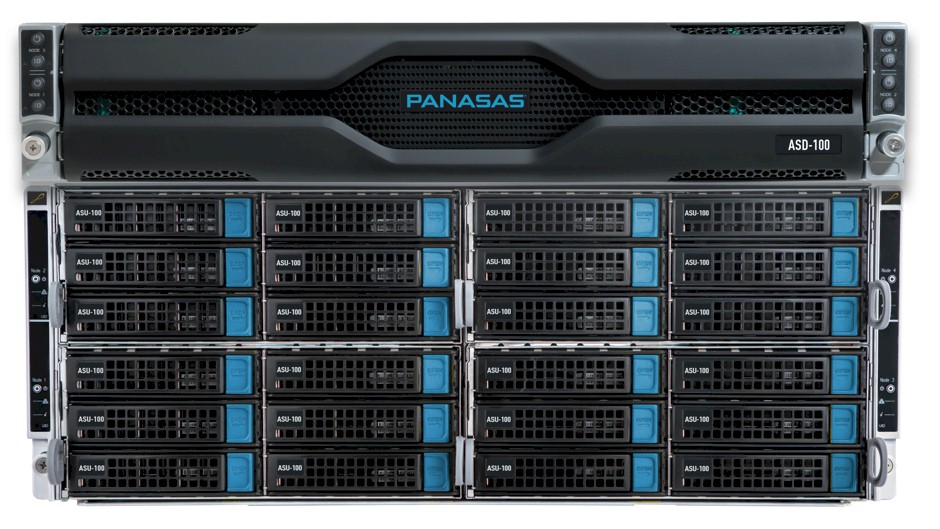

Achados como esse foram um dos motivos pelos quais o Panasas - que atende empresas que estão abaixo dos principais laboratórios nacionais e instituições similares em tamanho e necessidades - encomendou o estudo, que pesquisou organizações com receitas anuais que variam de menos de US $ 5 milhões a mais de US $ 10 bilhões.

Em conjunto com o estudo, Panasas colocou

uma nova calculadora de TCO em seu site para ajudar as organizações a descobrirem melhor seus próprios custos operacionais. Usando a calculadora, Panasas tirou a média de vários custos operacionais das respostas da pesquisa e calculou a média em cinco anos e depois comparou-os com os custos associados à sua tecnologia, com o resultado em quase US $ 12 milhões em economia de custos ao longo dos cinco anos.

When Hewlett Packard Enterprise finally closed on its $1.3 billion acquisition of supercomputer maker Cray in September, it was just over a month after

www.nextplatform.com

Como mostra o gráfico da Statista abaixo, a quantidade de dados gerados em todo o mundo em 2020 deverá atingir 50,5 zettabytes. Em 2025, serão criados 175 zettabytes.

@user101 @dayllann