You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

[TÓPICO DEDICADO] NAVI - próxima geração de GPUs da AMD

- Iniciador de Tópicos brender

- Data de Início

Existe alguma data/rumor de lançamento das 6700?

Deve sair após anuncio da 3060Ti em dezembro.

$$$$$$$$$$$$$$$$$$$$$$$$$$$$$Acho engraçado ver o povo usando 10900k nos testes(Nvidia/AMD) sendo que é FATO que os Ryzen 5000 patrolam esse Intel.

agora eles virão com essa novamente que10GB da pra 4K ultra da mesma forma que 1080p ultra com 4gb dava ai quem escutou e comprou as rx 480 de 4gb em vez das de 8 gb

Os dois. É possível aumentar o hithate da InfCache de acordo com o dado alocado na cache, e se o programador quiser otimizar em baixo nível (afinal de contas, já estamos no DX12 mesmo) ele poderá dar prioridade a alguns dados e forçar o controlador de memória a manter algo na cache ao invés de deixar que ele mande o dado de volta à VRAM. Claro que isso aumentará o desempenho em todas as situações do jogo, e não apenas em 4K, essa resolução dificulta a InfCache porque ela oferece muitos pixels a serem processados, então sempre irá ter um desempenho inferior mas é passível de otimização.Traduzindo: drivers melhores ou otimizações/atualizações específicas em cada jogo? Ou os dois?

Quanto ao driver, ele pode se comunica de forma mais íntima com a placa e até priorizar/repriorizar dados para ficarem permanentemente na InfCache, descer para a L2 ou nunca ser alocado em nenhuma cache, mas aqui as otimizações são mais generalistas que específicas, entende? É como programar um emulador: Primeiro você faz ele para suportar o máximo de jogos possíveis, depois que ele faz isso de forma correta é que se começa a criar atalhos/rotinas específicas para cada jogo. É por causa disso que até hoje não existe um emulador 100% para 100% dos jogos, o bsnes/snes9x e pcsxe/epsxe estão nessa segunda a parte a mais de uma década xD

Inclusive o driver na RDNA2 é bem mais importante que nas gerações anteriores: Agora o Adrenalin ficará responsável por adicionar ILP ao decompilar o código para a GPU, e também converterá os shaders comuns em primitivos/Mesh, já que os desenvolvedores das engines/jogos não fazem isso a AMD precisará colocar a mão na massa. Ao menos com o DXR1.1 vai se tornar cada vez mais comum, mas enquanto não a GCN e RDNA1 perdem desempenho processando Geometry Shaders de forma separada no pipeline ao invés de processar de forma unificada como Mesh Shaders (uma evolução do Primitive Shader, criado pela AMD).

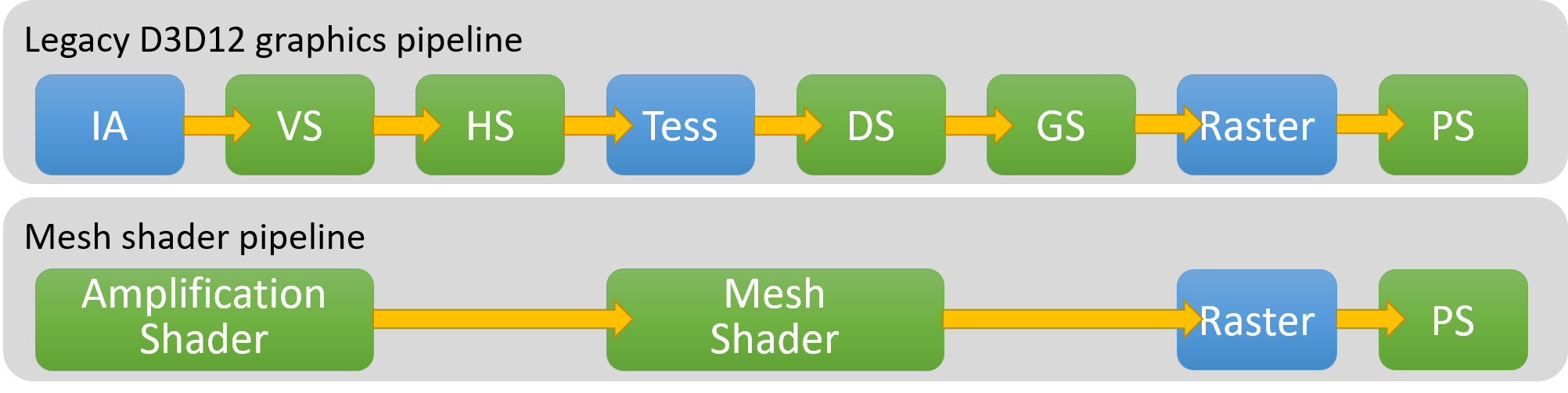

Essa questão acima é meio complexa de explicar, então vou deixar apenas uma imagem com a legenda abaixo, e uma explicação técnica vai em spoiler

Legenda:

IA = Assembler de Entrada

VS = Vertex Shader

HS = Hull Shader

Tess = Tesselador

DS = Domain Shader

GS = Geometry Shader

Raster = Rasterização

PS = Pixel Shader

Vamos utilizar o GPU Profiler, um programa da AMD para ver como o pipeline da GPU funciona dado um conjunto de dados a ser processados (um jogo, por exemplo). Sabemos que para a GPU não existe jogo ou dado, para ela é um thread que deve ser executado em uma onda (no RDNA2 essa onda tem um tamanho de 32 threads, a uma quantidade de 32 ondas por vez (no RDNA1 eram 40 ondas por vez)).

Nas duas imagens abaixo veremos um gráfico bem "louco" onde o pipeline é exposto, com o tempo que tantos threads levam para serem processados. Para simplificar nossa análise iremos prestar atenção apenas na parte superior da ocupação do Wavefront. Percebam que temos as cores amarelo, verde e azul no pipeline, e isso indica que a GPU está realizando computação (algo não gráfico, como física) na cor amarela, sombreamento de vértice na cor verde escuro, sombreamento de pixel na azul e um primitivo/mesh na cor roxa.

Na primeira imagem vemos a análise de uma cena na Radeon VII: Percebam que todas as cores que citei estão no gráfico, menos a cor roxa. Isso significa que o jogo em questão não usa Primitivos, e mesmo que usasse a Vega não permite eles serem usados (sim, elas possuem mas estão desativados, não tem como usá-los) e isso faz com que a GPU renda menos que o necessário. Na segunda imagem está sendo usada a 5700XT, e vemos que as cores continuam a mesma, mas no canto direito tem um contador que diz que tivemos 39 ondas de wavefronts de primitivos (~40 mil threads de Prims/Meshlets), ou seja, primitivos foram usados mas foram tão poucos que nem apareceram no gráfico, então o ganho de desempenho nesse sentido foi praticamente inexistente, mas quase 8% dos PixelShaders foram parar na unidade NGG (geometria de próxima geração) e isso é uma boa otimização pois permite que esse tipo de shader "execute mais rápido".

Agora o terceiro gráfico é bem interessante, pois nele a 6800XT é que está sendo analisada, e a figura muda completamente aqui: A cor verde escuro não existe mais (foi toda substituída pelo roxo) e isso reafirma que o jogo usa primitivos/mesh mas... esse jogo não usou tantos prims/meshlets assim na 5700XT, porque agora ele está usando na 6800XT? Simples, porque agora o driver está convertendo tudo o que pode ser prim/mesh em prim/mesh, e o que não pode ele tenta adicionar ILP (paralelismo a nível de instrução), jogando qualquer código de execução legada em um código otimizado de execução NGG (geometria de próxima geração).

Com isso o pipeline executa de uma forma muito mais enxuta e empurra a performance por watt para cima, ao custo de uma maior dependência do driver. De forma simples, a AMD decidiu seguir a tomada da concorrente (um driver que ajuda sua GPU) mas por um motivo diferente (porque os DEVs não fazem sua parte), então a AMD estará investindo pesado no driver de agora em diante e não atoa o Heiss falou que o driver do RDNA2 foi feito do zero.

Nas duas imagens abaixo veremos um gráfico bem "louco" onde o pipeline é exposto, com o tempo que tantos threads levam para serem processados. Para simplificar nossa análise iremos prestar atenção apenas na parte superior da ocupação do Wavefront. Percebam que temos as cores amarelo, verde e azul no pipeline, e isso indica que a GPU está realizando computação (algo não gráfico, como física) na cor amarela, sombreamento de vértice na cor verde escuro, sombreamento de pixel na azul e um primitivo/mesh na cor roxa.

Na primeira imagem vemos a análise de uma cena na Radeon VII: Percebam que todas as cores que citei estão no gráfico, menos a cor roxa. Isso significa que o jogo em questão não usa Primitivos, e mesmo que usasse a Vega não permite eles serem usados (sim, elas possuem mas estão desativados, não tem como usá-los) e isso faz com que a GPU renda menos que o necessário. Na segunda imagem está sendo usada a 5700XT, e vemos que as cores continuam a mesma, mas no canto direito tem um contador que diz que tivemos 39 ondas de wavefronts de primitivos (~40 mil threads de Prims/Meshlets), ou seja, primitivos foram usados mas foram tão poucos que nem apareceram no gráfico, então o ganho de desempenho nesse sentido foi praticamente inexistente, mas quase 8% dos PixelShaders foram parar na unidade NGG (geometria de próxima geração) e isso é uma boa otimização pois permite que esse tipo de shader "execute mais rápido".

Agora o terceiro gráfico é bem interessante, pois nele a 6800XT é que está sendo analisada, e a figura muda completamente aqui: A cor verde escuro não existe mais (foi toda substituída pelo roxo) e isso reafirma que o jogo usa primitivos/mesh mas... esse jogo não usou tantos prims/meshlets assim na 5700XT, porque agora ele está usando na 6800XT? Simples, porque agora o driver está convertendo tudo o que pode ser prim/mesh em prim/mesh, e o que não pode ele tenta adicionar ILP (paralelismo a nível de instrução), jogando qualquer código de execução legada em um código otimizado de execução NGG (geometria de próxima geração).

Com isso o pipeline executa de uma forma muito mais enxuta e empurra a performance por watt para cima, ao custo de uma maior dependência do driver. De forma simples, a AMD decidiu seguir a tomada da concorrente (um driver que ajuda sua GPU) mas por um motivo diferente (porque os DEVs não fazem sua parte), então a AMD estará investindo pesado no driver de agora em diante e não atoa o Heiss falou que o driver do RDNA2 foi feito do zero.

Isso, como disse ele apenas está assumindo algo pela lógica, resolução alta requer alta largura de banda, mas ele está esquecendo que o InfCache adiciona uma nova variável na mesa e essa nova "largura de banda efetiva" é que deve ser levada em consideração agora, até para se comparar a RDNA2 com outras GPUs é mais difícil agora (até porque agora a velocidade efetiva varia de acordo com a resolução e clock da placa, então no modo turbo ela entregará uma vazão enquanto que no clock base ela entregará outra). De forma extremamente simplificada, a largura de banda efetiva de uma RX 6800XT é 1.6TB/s, e não 512GB/s, este segundo valor é a largura de banda da memória, não da placa, e isso é que tem que ficar claro de hoje em diante: 1.6TB/s de largura de banda efetiva ou 1.8Tb/s + 512GB/s de largura de banda real.Nada contra o Marcus mas acho muito errado essas afirmações, a tese dele é apenas no achismo é muito facil jogar a culpa nas memoria , mas provar que é isso é outros 500, o Igor'sLab ao meu ver é muito mais capacitado para isso doque o marcus que nem sequer tem acesso a placa ainda.

Fora que não é segredo pra ninguém que os drivers , principalmente AMD sempre tem muita margem pra melhorar , fora que 5-8% menos performance ta muito longe desse derreteu que ele fala tanto.

Inclusive já deixei a fórmula aqui de como se chega na vazão efetiva da RDNA2:

[TÓPICO OFICIAL] - NAVI - próxima geração de GPUs da AMD

Me pergunto de quanto será o ganho prático de performance na faixa de U$400. Pelo que vi, a RX 6800 é ~40% mais rápida que a 5700 XT e 45% mais cara. Parece mais com a chegada da linha "premium" do que uma nova geração.

Última edição:

É só fazer produto que presta, coisa que ela não tem feito nas VGAs.

Então as RX 6000 não prestam? Por isso as críticas imparciais aos produtos dela?

Cuidado com sua linha de argumentação.

Então as RX 6000 não prestam? Por isso as críticas imparciais aos produtos dela?

Cuidado com sua linha de argumentação.

Linha de argumentação? Meus argumentos são os fatos. Essa nova série acabou de ser lançada, então não se pode bater no peito e dizer que é boa assim como também não se pode afirmar o contrário. Obviamente não estou me referindo a série que acabou de ser lançada.

E aqui não tem paixão por marca amigo. Ainda bem que vc sabe que minhas críticas são imparciais.

Como discussões de internet sempre são 8 ou 80.

Temos apenas 2 empresas que fazem VGA, se uma delas tiver o produto um pouco melhor é por que a outra "não presta", "é um lixo" , "foi esmagada" ou "destruída". Bem infanto...

Temos apenas 2 empresas que fazem VGA, se uma delas tiver o produto um pouco melhor é por que a outra "não presta", "é um lixo" , "foi esmagada" ou "destruída". Bem infanto...

Como discussões de internet sempre são 8 ou 80.

Temos apenas 2 empresas que fazem VGA, se uma delas tiver o produto um pouco melhor é por que a outra "não presta", "é um lixo" , "foi esmagada" ou "destruída". Bem infanto...

Sugiro que pesquise e se informe. Porque não tô falando de rodar com fps 15 % superior ou inferior. Estou falando de problemas. Relatos não faltam e o Google é seu amigo.

O mercado também diz muito. Quando determinada marca tem bons produtos, eles vendem bem e são recomendados. É simples e objetivo. Sem paixões.

Errado, se vender muito fosse sinal de qualidade onix não venderia igual aguaO mercado também diz muito. Quando determinada marca tem bons produtos, eles vendem bem e são recomendados. É simples e objetivo. Sem paixões.

.

.O mercado não funciona assim... Marketing > Qualidade

A AMD tem sim seus problemas, porem ela sempre foi a segunda opção da galera.

Um exemplo bem simples foi a época da 480 vs 1060, todo mundo falava compra 1060 ela é melhor, Nvidia bla bla bla.

Agora fala hoje com quem comprou uma 1060 aquela época?

Eu mesmo troquei uma 1060 por uma 580 pau a pau, dizendo o cara AMD não prestava, quem saiu no lucro fui eu

Me fez lembrar de um comentário engraçado que eu lia nessa época:

- Quero uma placa que entrega performance agora, essa conversa de melhorar com drivers da AMD não existe, 6GB é o suficiente.

Tudo acontecendo novamente...

- 8GB para 4k é suficiente

Última edição:

Sugiro que pesquise e se informe. Porque não tô falando de rodar com fps 15 % superior ou inferior. Estou falando de problemas. Relatos não faltam e o Google é seu amigo.

O mercado também diz muito. Quando determinada marca tem bons produtos, eles vendem bem e são recomendados. É simples e objetivo. Sem paixões.

Hoje uma 1060 é inferior a uma 470.. realmente, Nvidia é ótima, pessoal compra pela qualidade sim, não pelo Marketing.

Hoje uma 1060 é inferior a uma 470.. realmente, Nvidia é ótima, pessoal compra pela qualidade sim, não pelo Marketing.

Não entendo qual a necessidade que o cara tem de vir num tópico da AMD e chamar os produtos dela de bosta.

Avisa lá pros milhares de reviews que eles analisaram a toa entãoLinha de argumentação? Meus argumentos são os fatos. Essa nova série acabou de ser lançada, então não se pode bater no peito e dizer que é boa assim como também não se pode afirmar o contrário. Obviamente não estou me referindo a série que acabou de ser lançada.

E aqui não tem paixão por marca amigo. Ainda bem que vc sabe que minhas críticas são imparciais.

--- Post duplo é unido automaticamente: ---

e-penis, deve ter comprado uma 3080 10gb pra 4k, tá vendo que fez merda e tá batendo o desespero.Não entendo qual a necessidade que o cara tem de vir num tópico da AMD e chamar os produtos dela de bosta.

PowerColor Radeon RX 6800 Red Dragon pictured - VideoCardz.com

PowerColor unleashes Red Dragon AMD Radeon RX 6800 XT and RX 6800 custom models will officially launch this Wednesday, on November 25th. Meanwhile, board partners are those shipping cards to reviewers and retailers. There aren’t many custom models that were not shown yet, but we still managed to...videocardz.com

Parece que faltou material e não conseguiram terminar de fechar a placa...a 6800XT de referência tem um acabamento mais refinado e melhor solução.

Pelo q eu acompanhei lá no tópico das verdinhas a maioria desses caras estão usando a auto-ilusão de q pra 4k não precisa mais do que 10GB por pelo menos uns 4 anos, outra parte da galera fala q 4k só vai ser viável daqui 3 ou 4 anosAvisa lá pros milhares de reviews que eles analisaram a toa então

--- Post duplo é unido automaticamente: ---

e-penis, deve ter comprado uma 3080 10gb pra 4k, tá vendo que fez merda e tá batendo o desespero.

verdade e olhando na foto parece ter um acabamento bem barato não gostei nem um pouco dessa versãoParece que faltou material e não conseguiram terminar de fechar a placa...a 6800XT de referência tem um acabamento mais refinado e melhor solução.

Avisa lá pros milhares de reviews que eles analisaram a toa então

--- Post duplo é unido automaticamente: ---

e-penis, deve ter comprado uma 3080 10gb pra 4k, tá vendo que fez merda e tá batendo o desespero.

kkkkkk

Só fui de 3080 pq consegui um bom preço e jogarei em 1440p.

10GB pra 4K não vai segurar mais de 2 anos.

Os cara testam em jogo de 2018/2019, é claro que 10GB é suficiente. Mas veja os jogos saindo HOJE, tipo Godfall, Watch Dogs Legion, o próprio Cyberpunk 2077 pediu 10GB de VRAM em 4K RT.

Se hoje os jogos estão pedindo 10GB, imagine daqui 2 anos quando começarem a sair os next gen de verdade, feitos do zero pensando nos consoles com 16GB.

Normal, a galera vê qualquer coisa na net e tira como verdade absoluta.Como discussões de internet sempre são 8 ou 80.

Temos apenas 2 empresas que fazem VGA, se uma delas tiver o produto um pouco melhor é por que a outra "não presta", "é um lixo" , "foi esmagada" ou "destruída". Bem infanto...

O pior que esses 5 a 7 % irrisórios segundo eles é o quanto a Nvidia esta na frente da AMD em 4k .

E a 3080 também é mais cara, não ?!?...então tem que ver o custoxperformance se compensa esses 5 a 7% adicionais de performance.

Basta ver que ainda discutimos em fórums, a geração de hoje não usa e nem gosta disso, para eles é engessado e não prático, perda de tempo. Eles preferem ouvir o conteúdo mastigado por vTubers, e o problema disso é que informação nesse ritmo, quando errada, dissemina rápido pois o público em sua grande maioria não vai atrás da veracidade, ele acredita que quem vez o vídeo já foi atrás dessa informação. Tanto que já li cinco pessoas confirmando que o problema é largura de banda para o 4K da 6800XT, e ao perguntar de onde veio a confirmação dele, "do video do PCFacts".Essas são as consequências da internet, cheio de superficialidade, onde tem muito papagaio que repete o que um streamer de sucesso publica, retrato dos tempos modernos.

Já sou de outra geração, que não me importo com a imbecialidade de redes sociais e seus seguidores, prefiro dados concretos, coerentes, concisos, com base técnica e não o disse que disse e é o verdadeiro absoluto.

CES 2021, junto com a apresentação do Cezanne para notebooks.Existe alguma data/rumor de lançamento das 6700?

Mas segundo o Hekkerman a AMD adiantou o lançamento da sua linha intermediária, então ela pode aparecer próximo mês como resposta à 3060Ti, mas apenas a 6700XT já que a versão comum deve ficar para próximo ano mesmo, como resposta às demais placas da concorrente.

Não é estranho, o problema todo ai é a comparação com quem... o XesqueVara tem uma resposta resumida, creio que não precise se aprofundar aqui.Eu vi o vídeo e o título é click bait....No vídeo ele fala que acha estranho a 6800xt ser melhor em 1080 e 1440P e perder em 4K....E ele afirma que é por causa da largura de banda, se é isso ou não, não sei, mas que é estranho isso acontecer isso é..

Não é a Big Navi que é Limitada em Banda em 4k, É a Ampere que se sobresai em 4k... É diferente.

O problema é que o modelo de referência só será fabricado até o Q1 do próximo ano, ele sairá de linha, só ficará no mercado as custom =XParece que faltou material e não conseguiram terminar de fechar a placa...a 6800XT de referência tem um acabamento mais refinado e melhor solução.

---

Olhando para a parte mobile, já são duas informações: Navi21 com 150W e Navi22 com 100W. A primeira com 16GB e a segunda com 12GB e 10GB... será que essa versão de 10GB virá para o desktop?

Fanboy não cresce nunca. Nego deve ser velho, barbado, as vezes já até fez família, mas faz biquinho e fica putinho porque alguém falou mal de uma empresa que fabrica hardware. O nível de anencefalia é tão grande que fala que eu tô metendo o pau nos produtos da AMD, sendo que sou usuário de produtos da marca há anos, inclusive deixando claro na assinatura.

E tem um motivo óbvio pra acompanhar o tópico que não é pra ficar babando ovo de marca e sim saber informações da nova geração. Agora, se não pode criticar, peçam pra colocar nas regras e parem de resmungar porque alguém falou algo de uma empresa que caga pros fanboys dela.

Existe uma diferença óbvia do mercado de carros para o de placas de vídeo de computador. Aqui a coisa é muito mais objetiva do que subjetiva, apesar de ainda ter crianças que se deixam levar por paixão por marca (não estou dizendo ser o seu caso).

Cara, na época a 1060 era um pouco superior. Nada de outro mundo, mas era. A maioria usava full HD. Em 4K com os jogos mais pesados, a 480 passou a ser um pouco superior somente nos casos em que os 2gb a mais de Vram eram necessários. Não vejo nenhum grande problema. Eu mesmo na época optei por uma placa de 8gb pra ficar tranquilo por um tempo. Mas como falei, meu julgamento vai além de julgar se uma placa faz mais ou menos FPS que a outra (a não ser que exista uma diferença considerável).

Agora, eu ainda não vi alguém falar que pra 4K 8gb de vram é suficiente. Só se for para os jogos antes dessa nova geração. Se algum lunático falou isso, nem é digno de crédito porque até para os jogos atuais mais pesados em mundo aberto 8gb já tá no limite. Claramente pro futuro uma placa de 12gb vai se fazer necessária para 4K em alta qualidade porque mesmo 10gb serão engolidos em uns 3 anos por certos jogos.

Nossa, anos depois melhor em alguns poucos casos. 470 ainda? Parabéns. Manda a conta pra AMD pra ela fazer o depósito. Todo mundo é burro e se deixa levar pelo marketing se não compra o que vc acha legal.

Review não utiliza placa a longo prazo amiguinho. Sugiro que pesquise ou então continue fechando os olhos pra tudo o que não puxe saco de acordo com sua paixão.

E o meu PC tá na assinatura. Se eu tivesse comprado algo, estaria nela.

E tem um motivo óbvio pra acompanhar o tópico que não é pra ficar babando ovo de marca e sim saber informações da nova geração. Agora, se não pode criticar, peçam pra colocar nas regras e parem de resmungar porque alguém falou algo de uma empresa que caga pros fanboys dela.

Errado, se vender muito fosse sinal de qualidade onix não venderia igual agua.

O mercado não funciona assim... Marketing > Qualidade

A AMD tem sim seus problemas, porem ela sempre foi a segunda opção da galera.

Um exemplo bem simples foi a época da 480 vs 1060, todo mundo falava compra 1060 ela é melhor, Nvidia bla bla bla.

Agora fala hoje com quem comprou uma 1060 aquela época?

Eu mesmo troquei uma 1060 por uma 580 pau a pau, dizendo o cara AMD não prestava, quem saiu no lucro fui eu

Me fez lembrar de um comentário engraçado que eu lia nessa época:

- Quero uma placa que entrega performance agora, essa conversa de melhorar com drivers da AMD não existe, 6GB é o suficiente.

Tudo acontecendo novamente...

- 8GB para 4k é suficiente

Existe uma diferença óbvia do mercado de carros para o de placas de vídeo de computador. Aqui a coisa é muito mais objetiva do que subjetiva, apesar de ainda ter crianças que se deixam levar por paixão por marca (não estou dizendo ser o seu caso).

Cara, na época a 1060 era um pouco superior. Nada de outro mundo, mas era. A maioria usava full HD. Em 4K com os jogos mais pesados, a 480 passou a ser um pouco superior somente nos casos em que os 2gb a mais de Vram eram necessários. Não vejo nenhum grande problema. Eu mesmo na época optei por uma placa de 8gb pra ficar tranquilo por um tempo. Mas como falei, meu julgamento vai além de julgar se uma placa faz mais ou menos FPS que a outra (a não ser que exista uma diferença considerável).

Agora, eu ainda não vi alguém falar que pra 4K 8gb de vram é suficiente. Só se for para os jogos antes dessa nova geração. Se algum lunático falou isso, nem é digno de crédito porque até para os jogos atuais mais pesados em mundo aberto 8gb já tá no limite. Claramente pro futuro uma placa de 12gb vai se fazer necessária para 4K em alta qualidade porque mesmo 10gb serão engolidos em uns 3 anos por certos jogos.

Hoje uma 1060 é inferior a uma 470.. realmente, Nvidia é ótima, pessoal compra pela qualidade sim, não pelo Marketing.

Nossa, anos depois melhor em alguns poucos casos. 470 ainda? Parabéns. Manda a conta pra AMD pra ela fazer o depósito. Todo mundo é burro e se deixa levar pelo marketing se não compra o que vc acha legal.

Avisa lá pros milhares de reviews que eles analisaram a toa então

--- Post duplo é unido automaticamente: ---

e-penis, deve ter comprado uma 3080 10gb pra 4k, tá vendo que fez merda e tá batendo o desespero.

Review não utiliza placa a longo prazo amiguinho. Sugiro que pesquise ou então continue fechando os olhos pra tudo o que não puxe saco de acordo com sua paixão.

E o meu PC tá na assinatura. Se eu tivesse comprado algo, estaria nela.

Não entendo qual a necessidade que o cara tem de vir num tópico da AMD e chamar os produtos dela de bosta.

Esse cara ai adora arrumar treta pelos tópicos todos do fórum kkk só ignoro.

Da(s) última(s) vez(es) que vi essa "qualidade" de discussão, fecharam um tópico. Duas vezes...

idemEsse cara ai adora arrumar treta pelos tópicos todos do fórum kkk só ignoro.

A verdade é que esses 10GB da Nvidia foi uma grande cagada, deu uma boa margem para a AMD conquistar terreno no espaço das Highend, caso contrário, a 3080 estaria bem consolidada.kkkkkk

Só fui de 3080 pq consegui um bom preço e jogarei em 1440p.

10GB pra 4K não vai segurar mais de 2 anos.

Os cara testam em jogo de 2018/2019, é claro que 10GB é suficiente. Mas veja os jogos saindo HOJE, tipo Godfall, Watch Dogs Legion, o próprio Cyberpunk 2077 pediu 10GB de VRAM em 4K RT.

Se hoje os jogos estão pedindo 10GB, imagine daqui 2 anos quando começarem a sair os next gen de verdade, feitos do zero pensando nos consoles com 16GB.

Em todos os jogos em 4k a 3080 reduziu ou ampliou a vantagem, acho um exagero essa história do Vram. Mesmo no Watch Dogs e no Godfall ocorreu o mesmo

Essa mesma discussão ocorre quase todas as gerações. Lembro-me disso desde a série Geforce 8800 GT / GTS / GTX, para 1080p / 1200p - resoluções que consideramos totalmente normais hoje em dia.

O resultado final para jogos de alta resolução sempre foi o mesmo: o poder de processamento da GPU sempre será o principal fator limitante, muito antes das limitações de VRAM se tornarem aparentes. Como estamos atingindo sólidos níveis de 4K 60 fps de desempenho jogável, o próximo passo lógico é subir mais uma vez para resoluções de tela ainda mais altas. Historicamente, sempre foi assim, e não prevejo essa mudança, a menos que haja uma estagnação na pesquisa e desenvolvimento de painéis.

Portanto, se / quando as telas de 5K / 6K / 8K se tornarem mais realisticamente alcançáveis nos próximos anos, você verá a mesma tendência ocorrer novamente, onde mesmo uma 3080 20GB também seria prejudicada porque a GPU luta para processar tantos pixels, não para armazená-los.

Além disso, os desenvolvedores precisam desenvolver para o menor denominador comum. Enquanto as placas de 6GB / 8GB dominarem o mercado nos próximos anos, não vejo 10GB como um gargalo realista - mesmo para 4K - por um longo tempo. No momento em que 10GB se tornar "insuficiente", a geração Nvidia daquele momento futuro, inevitavelmente estará disponível.

Além disso, o GDDR6X é mais rápido, o que ajuda a reduzir a necessidade de capacidade. 10GB de GDDR6X é suficiente por agora e duvido que tenha dificuldades no futuro próximo (uns 3 anos mais ou menos, mas até lá já é outra geração de placas). Uma outra coisa é que VRAM alocada não é VRAM utilizada.

O resultado final para jogos de alta resolução sempre foi o mesmo: o poder de processamento da GPU sempre será o principal fator limitante, muito antes das limitações de VRAM se tornarem aparentes. Como estamos atingindo sólidos níveis de 4K 60 fps de desempenho jogável, o próximo passo lógico é subir mais uma vez para resoluções de tela ainda mais altas. Historicamente, sempre foi assim, e não prevejo essa mudança, a menos que haja uma estagnação na pesquisa e desenvolvimento de painéis.

Portanto, se / quando as telas de 5K / 6K / 8K se tornarem mais realisticamente alcançáveis nos próximos anos, você verá a mesma tendência ocorrer novamente, onde mesmo uma 3080 20GB também seria prejudicada porque a GPU luta para processar tantos pixels, não para armazená-los.

Além disso, os desenvolvedores precisam desenvolver para o menor denominador comum. Enquanto as placas de 6GB / 8GB dominarem o mercado nos próximos anos, não vejo 10GB como um gargalo realista - mesmo para 4K - por um longo tempo. No momento em que 10GB se tornar "insuficiente", a geração Nvidia daquele momento futuro, inevitavelmente estará disponível.

Além disso, o GDDR6X é mais rápido, o que ajuda a reduzir a necessidade de capacidade. 10GB de GDDR6X é suficiente por agora e duvido que tenha dificuldades no futuro próximo (uns 3 anos mais ou menos, mas até lá já é outra geração de placas). Uma outra coisa é que VRAM alocada não é VRAM utilizada.