Passamos de uma 3080 com o chip da 3090 (628mm² - ligeiramente menor que os 609mm² da 4090) vendida a $699 pra uma 4080 de 379mm² vendida a $1199.

Não tem justificativa que possa sustentar esse absurdo, tanto que lançaram um chip mais "completo" por $999 sem nem pensar.

A 4090, o chip mais complexo da linha gamer, não sofreu alterações expressivas de preço ($100).

Aconselho a quando fazer comparações de preço por área, colocar as Ampere de fora xD

Falando sério, falei sério, a NVIDIA pegou o fiasco de nó de 8nm da Samsung a preço de banana (memes na época diziam até que a SS pagou para o Jensen usar suas fabs), enquanto que o nó de 5nm da TSMC vem a preço premium, então estranho seria manter o mesmo preço. Não se tem valores exatos do quanto a verdinha pagou pelos wafers da coreana, mas lembro que o Charlie (do SemiAccurate) chegou a dizer que

"saiu quase de graça" e, em outro comentário numa conversa do Twitter, que

"era um desconto de, no mínimo, 50%". Então sim, a NVIDIA teve um lucro imenso na geração RTX3000, mesmo seus chips sendo enormes (justamente por ter um desconto desses que ela arriscou chips assim, com certeza a taxa de aproveitamento foi muito baixa).

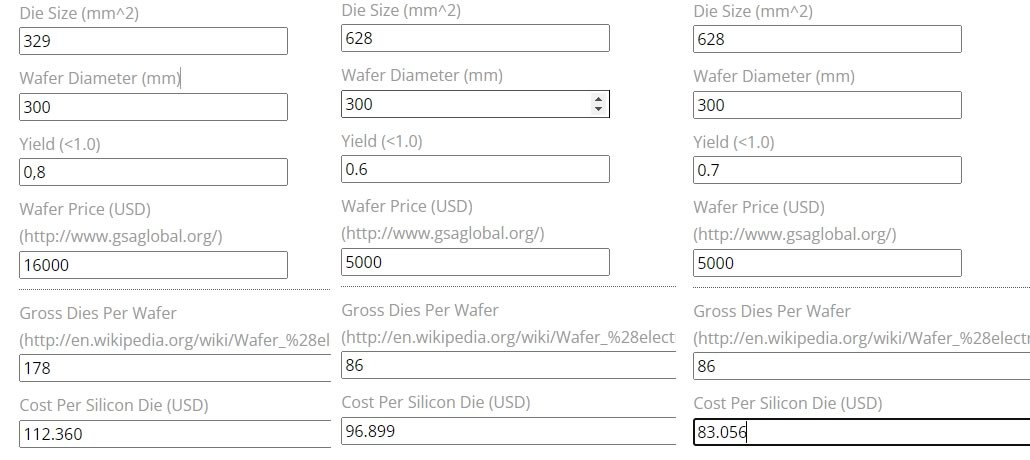

Só para aprofundar, custos das "bolachas":

- Turing -> TSMC 12nm = 4000 dólares por wafer

- Ampere (oficial) -> Samsung 8nm = 5000 dólares por wafer

- Ampere (rumor) -> Samsung 8nm = 2000 dólares por wafer (coloquei um desconto de 60% do valor base)

- Ada Lovelace -> TSMC 5nm = 17000 dólares por wafer

Se analisarmos o custo por mm², temos o seguinte em um wafer padrão de 300mm (70650mm²):

- Turing = 0,056 centavos de dólar por mm²

- Ampere (oficial) = 0,070 centavos de dólar por mm²

- Ampere (rumor) = 0,028 centavos de dólar por mm²

- Ada Lovelace = 0,240 centavos de dólar por mm²

Logo uma 4080 (379mm²) custa, para a NVIDIA, ~91 dólares para ser fabricada, enquanto que uma 3090 (628mm²) custava ~44 dólares de forma oficial ou ~18 dólares, segundo o rumor, para ser feita. Então mesmo sendo muito maior a 3090 era de 2x à 5x mais barata de ser fabricada que a 4080, ou seja,

a verdinha ganha menos por placa numa 4080 de 1200 dólares do que ganhava numa 3080 de 700 dólares. Claro que a quantidade de chips fabricado por wafer inverte essa """perda""" (são 89 chips de 628mm² ou 148 chips de 379mm²), mas não deixa de provar meu ponto:

As Ampere não podem entrar em um ring comparativo de forma justa, é preciso citar o nó e seu custo para se ter o escopo completo. Por fim, não estou justificando esse aumento absurdo para 1200 dólares, apenas de que o aumento viria e seria grande por voltar a usar a TSMC.

PS: Para efeito de comparação, o custo por wafer de 10nm da TSMC é de 6k dólar, então se a NVIDIA utilizasse esse nó ao invés dos 8nm da Samsung uma GPU de 628mm² custaria ~53 dólares, logo indo pelo pelo rumor e definindo o desonto como 60% dá para se ter uma bela noção do quanto ela economizou, economia essa que ela não conseguiu com a TSMC.