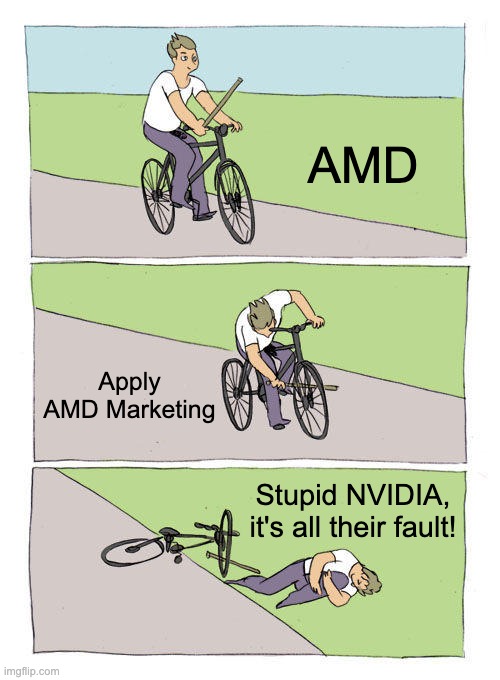

Pelos rumores, o RDNA 4 só irá parecer nas rx 9070 pra cima.Nvidia realmente não tem concorrência. AMD não falou das RDNA 4 na CES, mesmo com tantos rumores em cima.

Acho que era pra não passar vegonha.

Pelos rumores, o RDNA 4 só irá parecer nas rx 9070 pra cima.Nvidia realmente não tem concorrência. AMD não falou das RDNA 4 na CES, mesmo com tantos rumores em cima.

Pelo menos a apresentação serviu pra surrar gato morto(Intel)Pelos rumores, o RDNA 4 só irá parecer nas rx 9070 pra cima.

Acho que era pra não passar vegonha.

Pelos rumores, o RDNA 4 só irá parecer nas rx 9070 pra cima.

Acho que era pra não passar vegonha.

AMD não decepciona na decepção.Os rumores era de que seriam placas medianas, para competir com 4070/5070. Com preço baixo e apresentando o FSR 4 com tecnologia similar ao DLSS e melhor desempenho em Ray Tracing, acho que muita gente iria gostar.

Então na apresentação de agora, mencionaram brevemente sua existência e disseram que iriam falar mais em outro momento ainda nesse trimestre. O resto foi AI, AI, AI, AI.

A RTX 5090 de laptop usa o mesmo chip da 5080.Mas não teria de ter sido o mesmo para a 5080 por exemplo?

A 5090 de laptop já disseram usar o GB203, então é a 5080 nessa config que vc falou. Provavelmente isso vai aparecer como 5080 Super pra desktop depois kkkkkkkSim, provavelmente a 5080 é o chip da 5070Ti de Desktop

Desktop:

5090 - 32GB

5080 - 16GB

5070Ti - 16GB

5070 - 12GB

Laptop:

5090 - 24GB (deve ser ou a 5090 capada ou a 5080 com chips de 3GB GDDR7)

5080 - 16GB (chip da 5070Ti)

5070Ti - 12GB (chip da 5070)

Dá Asus eu fiquei tentado nos modelos de 14" sem dGPU deles. Como prefiro laptops com bateria grande e que sejam leves, evito qualquer modelos desses gamers, só dão dor de cabeça.Fato, tendência é Laptop mais finos com ótimo automação de bateria sem sacrificar muito a performance em jogos, estou curioso para ver os modelos da Asus mais especificamente o Zephyrus.

vou aproveitar pra ver as coisas da CES jaja (curioso pra ver a parte do strix halo), mas ouvi falar que evitaram falar das RDNA4 pra anunciar só depois que a nvidia fizesse o anúncio deles.Nvidia realmente não tem concorrência. AMD não falou das RDNA 4 na CES, mesmo com tantos rumores em cima.

Você vai sorrir quando AMD colocar o preço de um processador tipo 9800x3d por 800 dólaresPelo menos a apresentação serviu pra surrar gato morto(Intel)

esse preço vai ser do 9950X3DVocê vai sorrir quando AMD colocar o preço de um processador tipo 9800x3d por 800 dólares

vou aproveitar pra ver as coisas da CES jaja (curioso pra ver a parte do strix halo), mas ouvi falar que evitaram falar das RDNA4 pra anunciar só depois que a nvidia fizesse o anúncio deles.

Ou seja, vão precificar os produtos baseados no que a nvidia fizer, consumidor final tá lascado kkkkkrying

Sem dGPU a bateria dura bem mais, eu tenho o Zephyrus aqui com peso de 2.0Kg e rodo a maioria dos jogos em QHD + filtros sem problema fora que a tela dele é fantástica e com ajustes fino eu consigo quase 8hs fora da tomada.Dá Asus eu fiquei tentado nos modelos de 14" sem dGPU deles. Como prefiro laptops com bateria grande e que sejam leves, evito qualquer modelos desses gamers, só dão dor de cabeça.

Jaquetinha vai começar apresentando a 5090 a U$999,00Achei bem fraca essa apresentação da AMD. Mais uma vez uma VGA mediana. Mais tarde veremos o jaqueta preta. Vai colocar só a cabecinha.

e sem KYAchei bem fraca essa apresentação da AMD. Mais uma vez uma VGA mediana. Mais tarde veremos o jaqueta preta. Vai colocar só a cabecinha.

Igual quando uma placa da nvidia da série xxx80 custava 800 dólaresesse preço vai ser do 9950X3D

Como pirok não tem ombro se prepare.e sem KY

Terminei de ver agr a apresentação, que bosta de apresentação.Falaram do Strix Halo batendo uma 4090 em inferência.

Infelizmente a AMD já se tornou a Nvidia dos processadores, na gringa vc só encontra 7800X3D por $475 e o 9800X3D por mais de $600 pois a AMD esta liberando esses processadores a conta gotas(Tia Lisa seguindo a estratégia do tio Jensen), assim pouco importa se o msrp da 5090 for $1.5k~$2k, pela baixa oferta ela vai para os $3k.Igual quando uma placa da nvidia da série xxx80 custava 800 dólares

As placas estão consumindo mais sim, sem dúvidas. Por outro lado, a eficiência energética delas também tem melhorado bastante. Se vc pegar uma placa antiga e uma nova, e configurar a nova no mesmo TDP da antiga, a nova ainda sim vai ter uma vantagem de desempenho.Peço desculpas se eu falar uma besteira, mas a cada geração estou vendo essas placas terem um gasto excessivo de energia elétrica, podem até falar quem compra as placas mais top, não vai preocupar com isso, mas percebo que a cada ano, as placas, todas elas estão aumentando tanto neste quesito, e quero saber, por que?

Melhoria real, sem ser algo cosmético, que você percebe que os jogos estão sendo prejudicados real só pra justificar upgrade, que justifique trocar placa a cada geração não estou vendo, mas beber, essas placas estão bebendo muito, daqui a pouco, até quem tem painel solar, vai chiar.

Eu não jogo multiplayer, então não sou tão exigente naquela coisa de 4K, e etc.

O porquê teórico acho que é simples, não temos mais tanta redução de litografia quanto há anos atrás. Saltos de redução de 10 ou mais nanômetros de uma vez, de 28nm para 14nm como da Maxwell (GTX 900) para Pascal (GTX 1000). Fora que além de aumentar as shader units, texture mapping units e outros que compõe uma GPU tradicional, agora tem que aumentar os tensor cores e os ray-tracing cores para o machine-learning e aceleradores de ray-tracing, optical flow e etc. Para ter um salto verdadeiro de desempenho, tem que levar no limite esses chips. Uma coisa que me impressionou muito nas gerações mais recentes é o quanto eles aumentaram a frequência do núcleo em uma única geração. A 3080 ficava aí na faixa de uns 2000MHz, enquanto a 4090 chega a bizonhos 2800MHz e os rumores indicam que a 5090 ficará na faixa dos 3500MHz.Peço desculpas se eu falar uma besteira, mas a cada geração estou vendo essas placas terem um gasto excessivo de energia elétrica, podem até falar quem compra as placas mais top, não vai preocupar com isso, mas percebo que a cada ano, as placas, todas elas estão aumentando tanto neste quesito, e quero saber, por que?

Melhoria real, sem ser algo cosmético, que você percebe que os jogos estão sendo prejudicados real só pra justificar upgrade, que justifique trocar placa a cada geração não estou vendo, mas beber, essas placas estão bebendo muito, daqui a pouco, até quem tem painel solar, vai chiar.

Eu não jogo multiplayer, então não sou tão exigente naquela coisa de 4K, e etc.

Com undervolt tem uma puta melhora e é super simples e rápido, dá pra manter o desempenho stock com uns 10-15% menos consumo e se sacrificar lá uns 5% de desempenho deve conseguir reduzir na faixa de 30-40% de consumo então ao meu ver nem é um baita problemaPeço desculpas se eu falar uma besteira, mas a cada geração estou vendo essas placas terem um gasto excessivo de energia elétrica, podem até falar quem compra as placas mais top, não vai preocupar com isso, mas percebo que a cada ano, as placas, todas elas estão aumentando tanto neste quesito, e quero saber, por que?

Melhoria real, sem ser algo cosmético, que você percebe que os jogos estão sendo prejudicados real só pra justificar upgrade, que justifique trocar placa a cada geração não estou vendo, mas beber, essas placas estão bebendo muito, daqui a pouco, até quem tem painel solar, vai chiar.

Eu não jogo multiplayer, então não sou tão exigente naquela coisa de 4K, e etc.

Sai fora carioca, sou do RS.Carioca consegue ser uma desgraça até em fórum de tecnologia.

Alguém tem um link, em inglês mesmo, da apresentação da Nvidia por favor?

Vai assistir com salame italiano, doce em pote ou kinder bueno?Cerca de 1 hora e meia pra começar