Se vier com problema como sera q funciona a politica da OLX? Pq dependendo dos preços de 4070/4060 vou considerar 3080/3080Ti usada mesmo.Um ponto a favor das usadas (com NF e garantia, sempre) é que no OLX, pelo menos, dá pra pagar em 12x sem juros, aqui e ali aparecendo um cupom bom de desconto (mês passado tava com um de 10%).

Esses preços melhores das novas são todos no PIX, e nem sempre a pessoa tá com essa grana na mão.

Eu mesmo tô de olho em umas Vision usadas no OLX nessas condições acima, mas, aguardando aí algum cupom bom como esse de 10% que usei pra comprar a Gaming OC.

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

Eu concordo! Se tiver uma usada com 1 ano de garantia por exemplo, preço bom e parcelado sem juros... eu compraria. Inclusive, cheguei a negociar uma 3090 TUF usada mas não chegamos num acordo em valores no OLX.

Mas vocês acham tranquilo comprar com nota e dentro da garantia ainda, mesmo que a maioria dos lugares não aceitem a garantia se a nota estiver em nome de terceiros?

Lugares ou fabricantes? Pelo que ja lí a maioria aceitam a NF em nome de outrem... ou estou errado?Mas vocês acham tranquilo comprar com nota e dentro da garantia ainda, mesmo que a maioria dos lugares não aceitem a garantia se a nota estiver em nome de terceiros?

Pelo que leio por aí, não.. tem que ser no nome da pessoa que tá solicitando na grande maioria dos lugares.Lugares ou fabricantes? Pelo que ja lí a maioria aceitam a NF em nome de outrem... ou estou errado?

Só pra deixar claro que já comprei muita coisa usada, só nunca precisei usar a garantia.

Eu comprei a 3090 por lá, só libera a grana depois que eu confirmo que tá tudo certo, caso contrário acho que daria pra devolver.Se vier com problema como sera q funciona a politica da OLX? Pq dependendo dos preços de 4070/4060 vou considerar 3080/3080Ti usada mesmo.

A minha foi da gigabyte, parece ser chatinho mas pelo menos consegui registrar o produto no site deles, espero não precisar usar.Mas vocês acham tranquilo comprar com nota e dentro da garantia ainda, mesmo que a maioria dos lugares não aceitem a garantia se a nota estiver em nome de terceiros?

Lugares ou fabricantes? Pelo que ja lí a maioria aceitam a NF em nome de outrem... ou estou errado?

A ASUS exige um termo de transferência de propriedade do propietário original registrado em cartório.

com a morte da galax como opção de garantia, e a asus exigindo registro em cartório o que ninguém que te vender algo vai se preocupar em ter este trabalho, nos resta os 3 anos da msi, sabe se ela exige algo semelhante?A ASUS exige um termo de transferência de propriedade do propietário original registrado em cartório.

E 3 anos da gigabyte também, 4 na linha aoruscom a morte da galax como opção de garantia, e a asus exigindo registro em cartório o que ninguém que te vender algo vai se preocupar em ter este trabalho, nos resta os 3 anos da msi, sabe se ela exige algo semelhante?

Não se preocupe que daqui a pouco a MSI e a Gigabyte também alteram a garantia para 2 anos e as outras marcas com esse prazo de garantia, como a Galax, voltam a ser opção.com a morte da galax como opção de garantia, e a asus exigindo registro em cartório o que ninguém que te vender algo vai se preocupar em ter este trabalho, nos resta os 3 anos da msi, sabe se ela exige algo semelhante?

mds cara kkkA ASUS exige um termo de transferência de propriedade do propietário original registrado em cartório.

Acho que Isso é uma cláusula exorbitante.A ASUS exige um termo de transferência de propriedade do propietário original registrado em cartório.

Algum "Adevogado" de plantão para esclarecer a dúvida

Acho que Isso é uma cláusula exorbitante.

Algum "Adevogado" de plantão para esclarecer a dúvida

Recebi essa orientação diretamente do suporte da ASUS por e-mail. Entrei em contato esta semana justamente porque estava considerando pegar uma placa de segunda mão.

Seria bom entrar em contato com o PROCON e encaminhar a resposta da Asus para eles só para saber se eles podem ou não exigir esse termo. Aí depois conta pra "nóis"Recebi essa orientação diretamente do suporte da ASUS por e-mail. Entrei em contato esta semana justamente porque estava considerando pegar uma placa de segunda mão.

é... a EVGA vai fazer falta

Não sabia que tinha essa coisa de cartório e afins... bom, a minha placa possui 3 anos, então to tranquilo hahahaha E no site da Galax nao precisa registrar tb!

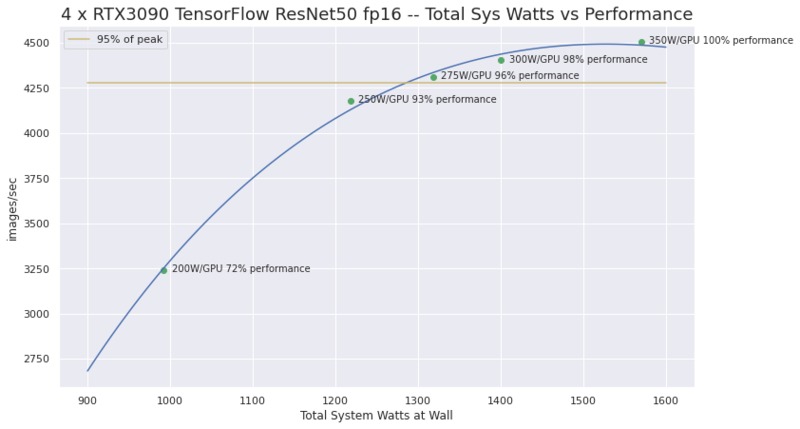

Hoje foi o dia de usar ela pra valer com oq tava mexendo na 3060, e a placa é um MONSTRO.Rodando uns testes agora, primeiro avaliando os diferentes valores com power limits variados, no bench do resnet com fp16 e batch_size de 128:

250W - 1074.36 imgs/sec

275W - 1125.18 imgs/sec

300W - 1151.24 imgs/sec

350W - 1241.81 imgs/sec

370W - 1233.22 imgs/sec (padrão da GPU é esse)

390W - 1254.26 imgs/sec (limite máximo da bios dessa GPU, rodei com o cu na mão por conta da fonte)

Acima de 350W nem há ganhos, não sei se é gargalo do workload em si ou se já tá na área dos diminishing returns mesmo, vou usar os 370W que vem por padrão pros demais testes.

Lembrando que de acordo com a pugetsystems, eles observaram que 250W entregava 93% do desempenho, 275 era 95% e 300W dava 98%, vide:

Quad RTX3090 GPU Wattage Limited "MaxQ" TensorFlow Performance

Can you run 4 RTX3090's in a system under heavy compute load? Yes, by using nvidia-smi I was able to reduce the power limit on 4 GPUs from 350W to 280W and achieve over 95% of maximum performance. The total power load "at the wall" was reasonable for a single power supply and a modest US...www.pugetsystems.com

Nos meus testes ali, 300W foi 90% do desempenho, 275W entregou 90%, e 250W entregaram 86%. Acho que vou usar 275W no dia a dia, a fonte deve aguentar de boas mesmo com o sistema todo em full load.

Atualizando minha tabelinha agora:

Código:+-------------------+---------------+----------------+----------------+----------------+----------------+---------------+----------------+----------------+----------------+----------------+-----------------+ | GPU-Imgs/s | FP32 Batch 64 | FP32 Batch 128 | FP32 Batch 256 | FP32 Batch 384 | FP32 Batch 512 | FP16 Batch 64 | FP16 Batch 128 | FP16 Batch 256 | FP16 Batch 384 | FP16 Batch 512 | FP16 Batch 1024 | +-------------------+---------------+----------------+----------------+----------------+----------------+---------------+----------------+----------------+----------------+----------------+-----------------+ | 2060 Super | 172 | NA | NA | NA | NA | 405 | 444 | NA | NA | NA | NA | | 3060 | 220 | NA | NA | NA | NA | 475 | 500 | NA | NA | NA | NA | | 3080 | 396 | NA | NA | NA | NA | 900 | 947 | NA | NA | NA | NA | | 3090 | 435 | 449 | 460 | OOM | NA | 1163 | 1217 | 1282 | 1311 | 1324 | OOM | | V100 | 369 | 394 | NA | NA | NA | 975 | 1117 | NA | NA | NA | NA | | A100 | 766 | 837 | 873 | 865 | OOM | 1892 | 2148 | 2379 | 2324 | 2492 | 2362 | | Radeon VII (ROCm) | 288 | 304 | NA | NA | NA | 393 | 426 | NA | NA | NA | NA | | 6800XT (DirectML) | NA | 63 | NA | NA | NA | NA | 52 | NA | NA | NA | NA | +-------------------+---------------+----------------+----------------+----------------+----------------+---------------+----------------+----------------+----------------+----------------+-----------------+

E resultados do ai-benchmark pra comparar com a A100:

Device Inference Score: 24963

Device Training Score: 30678

Device AI Score: 55641

Como deu resultados maiores aqui? Chuto que sejam só testes com datasets pequenos onde minha CPU acaba fazendo diferença (a CPU do teste da A100 era capadinha) e os clocks maiores da 3090 ajudam.

Durante todos os testes não vi a GPU esquentar muito, não passou de 64º com as fans no máximo em 72% (e super silenciosas), sendo que meu quarto está com o ar em 23º, antes dos testes tava medindo 23.7º no ambiente (temperatura tirada a 1 palmo de onde a GPU tá enquanto idle):

Depois do teste subiu meio grau:

acho que quase 400W no ambiente esquentam um pouco rs

Ah, aproveitei que ia desligar o PC para colocar a placa e atualizei o sistema (faço a cada 1~2 semanas quando reinicio o PC, de resto ele fica 24/7), coloquei a placa, ligou, mas não inicializava o ambiente gráfico do meu sistema, já fiquei receoso achando que tinha dado ruim na placa de minerador. Depois de vasculhar vi que era só um bug do driver da nvidia, precisei tirar o hdmi, logar nas cegas e depois plugar o cabo, tudo certo.

Parece que a nvidia tá com vontade de deixar 1 bug por ano no linux agora.

Do jeito todo cagado que eu usava na 3060 e servia pra deixar ela em 100% de uso direto, na 3090 tá deixando data-starved e ela mal sobe o uso/clocks. Dificilmente consigo fazer ela passar dos 70% de uso com meu pipeline cagado (por outro lado, a vram veio super bem a calhar)

Agora é ter de escrever código direito como se tivesse na nuvem pagando por minuto pra deixar ela feliz.

pelo contrário, as outras marcas estão seguindo o caminho contrário, pny que não tinha garantia aqui agora tem, inno3d que não tinha garantia no br agora dá 3 anos, gigabyte que tem modelos com 4 anos, asus e msi mantendo 3 anos, palit que não tinha garantia aqui agora tem, só a galax retrocedeu, marca que não tinha espaço no mercado nacional, apareceu aqui e após obter relativo sucesso agora pisa no pé do consumidorNão se preocupe que daqui a pouco a MSI e a Gigabyte também alteram a garantia para 2 anos e as outras marcas com esse prazo de garantia, como a Galax, voltam a ser opção.

Certamente dá pra contestar, mas nesse meio tempo o cara fica mofando e sem uma placa para usar.Seria bom entrar em contato com o PROCON e encaminhar a resposta da Asus para eles só para saber se eles podem ou não exigir esse termo. Aí depois conta pra "nóis"

é... a EVGA vai fazer falta

Eu mesmo já tive que acionar a garantia de uma GPU Asus de segunda mão e precisei "correr o trecho" para conseguir esse termo de doação, felizmente o vendedor era gente boa e no final deu tudo certo. Hoje se fosse pegar uma placa usada eu certamente vincularia a compra ao termo, se o cara tem interesse em vender isso não é o fim do mundo.

"Agora" seria desde quando? E de quanto tempo é a garantia dessas outras marcas?pelo contrário, as outras marcas estão seguindo o caminho contrário, pny que não tinha garantia aqui agora tem, inno3d que não tinha garantia no br agora dá 3 anos, gigabyte que tem modelos com 4 anos, asus e msi mantendo 3 anos, palit que não tinha garantia aqui agora tem, só a galax retrocedeu, marca que não tinha espaço no mercado nacional, apareceu aqui e após obter relativo sucesso agora pisa no pé do consumidor

Várias delas só tem/tinham garantia pela loja e essa parte não é novidade, se vc tiver alguma informação mais fresca seria interessante compartilhar no tópico de garantias (link), se possível com referências do site deles e/ou da empresa que presta o suporte no BR.

Eles fazem isso justamente pra te vencer no cansaço.Certamente dá pra contestar, mas nesse meio tempo o cara fica mofando e sem uma placa para usar.

Eu mesmo já tive que acionar a garantia de uma GPU Asus de segunda mão e precisei "correr o trecho" para conseguir esse termo de doação, felizmente o vendedor era gente boa e no final deu tudo certo. Hoje se fosse pegar uma placa usada eu certamente vincularia a compra ao termo, se o cara tem interesse em vender isso não é o fim do mundo.

"Agora" seria desde quando? E de quanto tempo é a garantia dessas outras marcas?

Várias delas só tem/tinham garantia pela loja e essa parte não é novidade, se vc tiver alguma informação mais fresca seria interessante compartilhar no tópico de garantias (link), se possível com referências do site deles e/ou da empresa que presta o suporte no BR.

Exatamente, muitas outras marcas também fazem isso mas grande parte das placas nunca precisará de suporte (ainda bem), isso sem falar que muita gente desconhece que algumas marcas/modelos tem mais de 12 meses de garantia, acabam considerando apenas o que estava escrito no site onde comprou e se/quando precisarem de algo mandam para alguma assistência qualquer, enfim...Eles fazem isso justamente pra te vencer no cansaço.

Da minha parte posso dizer o seguinte: Após esse episódio me comprometi a não comprar mais componentes desde tipo($) usados, só em último caso ou se o valor justificar a provável inexistência de garantia, não quero mais este tipo de sarna pra me coçar.

A ASUS exige um termo de transferência de propriedade do propietário original registrado em cartório.

Galax é assim tb. A Asus passei por isso, deu RMA mas só depositavam em conta do CPF da nota ou com doc registrado em cartório autorizando depósito pra outro titular. Isso começou em 2018 com a mineração, aumentou RMA e inventaram essa pra se livrar do custo nas placa de segunda mão.

Guys,eu comprei um 3080 da Gigabyte usada e registrei no site.vendo os comentários sobre rma,com a Giga é de boas se

o produto for registrado?

o produto for registrado?

Tem nota fiscal, certo? O site deles menciona bastante "nota fiscal original" e "usuário final original", dando a entender que só vai falar com o titular da NF.Guys,eu comprei um 3080 da Gigabyte usada e registrei no site.vendo os comentários sobre rma,com a Giga é de boas se

o produto for registrado?

No mesmo link acima há o contato da gbsc que é a empresa que presta suporte, sugiro entrar em contato com eles para tirar suas dúvidas.

Pra todo mundo que quiser falar sobre garantia, suporte e afins sugiro concentrar no tópico dedicado.

Você não quis dizer EVGA? Não entendi essa morte da Galax como opção de garantia.com a morte da galax como opção de garantia, e a asus exigindo registro em cartório o que ninguém que te vender algo vai se preocupar em ter este trabalho, nos resta os 3 anos da msi, sabe se ela exige algo semelhante?

Users who are viewing this thread

Total: 2 (membros: 0, visitantes: 2)